Seiner Zeit vor raus

100 Jahre John von Neumann

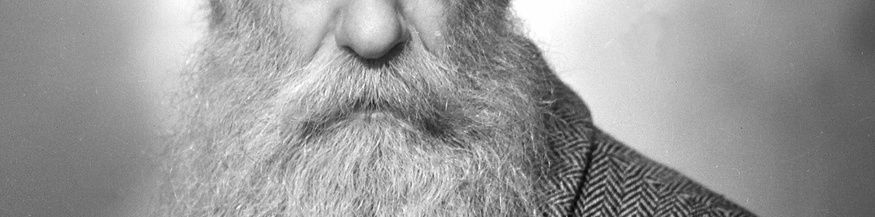

Vor hundert Jahren im Dezember 1903 wurde der Mathematiker John von Neumann in Budapest geboren. 1945 verfasste er in den USA Vorschläge für den Bau von elektronischen Rechnern. Bis heute entsprechen fast alle Computer dieser "Von-Neumann-Architektur".

8. April 2017, 21:58

Wolfgang Coy, Humboldt-Universität Berlin über die Rolle John von Neumanns in der Informatik

Viele Anekdoten ranken sich um die vielseitige Persönlichkeit von John von Neumann. Seine schnelle Auffassungsgabe und auch seine Fähigkeiten im Kopfrechnen sind legendär. Als der Mathematiker Mitte der vierziger Jahre des zwanzigsten Jahrhunderts beginnt, sich mit elektronischen Rechnern zu beschäftigen, hat er schon einen weiten Weg hinter sich.

Dieser führt ihn von Budapest über Zürich und Berlin ab 1930 ins amerikanische Princeton an das dort neu entstehende berühmte "Institute for Advanced Studies". Wenige Jahre später arbeitet von Neumann am Manhattan-Projekt mit, das die erste amerikanische Atombombe entwickelt. Von dort führt der Weg direkt nach Washington, ins Zentrum der Macht. Bis zu seinem frühen Tod 1957 ist er dort als Regierungsberater tätig.

"Doktor Seltsam"

Aufgrund einer Krebserkrankung ist er die letzten Jahre seines Lebens auf einen Rollstuhl angewiesen. Am Schnittpunkt zwischen Wissenschaft, Politik und Militär wird von Neumann eine der treibenden Kräfte hinter der amerikanischen Atomrüstung im beginnenden kalten Krieg. Als "Doktor Seltsam", für den er eines der Vorbilder abgegeben haben soll, wurde diese letzte Phase seines Lebens auch im Film verewigt.

In seiner Laufbahn als Wissenschaftler hat von Neumann Wesentliches zu einer ganzen Reihe von Disziplinen beigetragen, neben seiner eigenen, der Mathematik, auch zur Physik, mit seinen Berechnungen zur Quantenmechanik, oder mit der berühmten Spieltheorie zur Ökonomie.

Die "von Neumann-Architektur"

In "First Draft of a Report on the Electronic Discrete Variable Calculator" entwarf John von Neumann 1945 ein Design für elektronische Rechner, nach dem fast alle Computer bis heute aufgebaut sind.

Eines der wesentlichen Elemente der von Neumann-Architektur, der Speicher, in dem sowohl Daten als auch Programme abgelegt werden, und damit die Technik des speicherprogrammierten Computers, wurde schon vor von Neumann angedacht. Konrad Zuse etwa in Deutschland aber auch amerikanische Forscher arbeiteten in diese Richtung. Für den Erfolg der von Neumann Architektur war aber unter anderem die Kombination mit der schnellen, seriellen Abarbeitung einzelner Rechenschritte in einer einzigen, zentralen Recheneinheit wichtig. Gegenentwürfe, die stärker auf parallele Verarbeitung setzten, scheiterten an der Komplexität der Programmierung und der Systemarchitektur.

Gebaut wurden elektronische Rechenmaschinen in den vierziger und frühen fünfziger Jahren als Werkzeuge für Mathematiker. Von Neumann selbst etwa stand vor dem Problem, die Stosswellen-Gleichung für eine Wasserstoffbombenexplosion berechnen zu müssen. Umso erstaunlicher ist, dass von Neumanns Konzept bis in die heutige Zeit bestand hat, in der Computer zahlreich Aufgaben in vielen verschiedenen Anwendungsfeldern erledigen.

Die Komplexität der Intelligenz

Auch auf einem anderen Feld hat sich John von Neumann als Visionär erwiesen. 1948 erschien Norbert Wiener´s "Cybernetics, or Control and Communication in the Animal and the Machine" und begründete die Wissenschaft der Kybernetik. Grosse Hoffnungen wurden geweckt. Es war die Rede vom Elektronengehirn, das dem Menschen bald ebenbürtig sein oder in sogar übertreffen würde.

1958 erschien posthum von Neumanns Buch zu diesem Thema: "The Computer and the Brain". Von Neumann interessierte sich für das Gehirn in der Hoffnung, vom Verständnis seiner Funktion etwas für den Bau von elektronischen Rechnern zu lernen. Bald war ihm klar, dass es da nicht sehr viel zu lernen gab, weil das Gehirn nach ganz anderen Prinzipien arbeitet als elektronische Schaltkreise.

Besonders die hochverteilte, parallele Arbeitsweise lebender Systeme würde eine technische Nachbildung vor große Probleme stellen. Von Neumann ging sogar soweit, dass es einer ganz neuen Form von Logik und mathematischen Modellen bedürfte, um derartige Systeme überhaupt richtig zu verstehen.

Ein realistischer Visionär

Mit dieser Skepsis im Bezug auf die Machbarkeit von künstlicher Intelligenz hat von Neumann im Wesentlichen bis heute Recht behalten. Die klassische Logik und Mathematik sind zwar immer noch an ihrem Platz, was es aber heute an Modellen zur Beschreibung von Leistungen des Gehirns gibt, bedient sich hochspezialisierter Methoden.

Die Informationsübertragung im Gehirn geschieht nicht nur auf elektrischem sondern auch auf chemischem Wege. Um derartige Phänomene abzubilden, bedient man sich komplexer Systeme von Differential-Gleichungen. Unter Einsatz gewaltigen Rechenleistungen gelingt es dabei nur ansatzweise Gehirnleistungen abzubilden.

Theorie stimmt bis heute

In seiner Automatentheorie hat John von Neumann auch die Frage untersucht, ob es einen sich selbst reproduzierenden Automaten geben könnte. Er kam zu dem Schluss, ein System von hinreichender Komplexität würde diese Fähigkeit besitzen. Die entscheidende Frage im Zusammenhang mit der künstlichen Intelligenz ist aber vielleicht, wie komplex ein System sein muss, um sich selbst vollständig zu verstehen.

John von Neumanns Ansätzen folgend könnte etwa die vollständige Beschreibung der Funktionen des menschlichen Gehirns so groß werden, dass sie von einem einzelnen Menschen nicht mehr verstanden werden kann. Bis jetzt spricht alles dafür, dass das zutrifft.