ORF/FOX

matrix

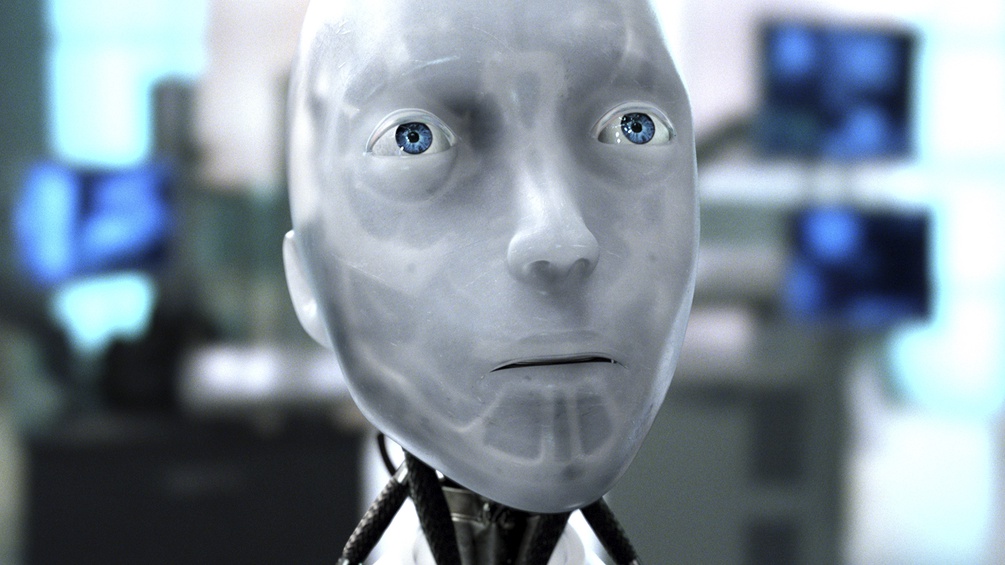

Wenn sich Maschinen für unsere Emotionen interessieren

Das Gesicht verrät, was wir denken und was wir fühlen, das hat Aristoteles schon festgestellt und viele haben ihm seither recht gegeben. Heute 2000 Jahre später sind mit KI verstärkte Maschinen dran und drauf in unserem Innersten zu lesen wie in einem Buch. So lauten die jüngsten Versprechen aus dem Silicon Valley und aus China.

29. Juni 2020, 02:00

Sendung hören

matrix 29 05 2020 19:05 Uhr

Die Werbebranche, Personaler aber auch die Polizei sind experimentierfreudige Abnehmer. So sollen Computer in der Lage sein, aus subtilen Gesichtsausdrücken herauszulesen, ob ein Bewerber für einen Job geeignet ist oder nicht. Wissen Maschinen tatsächlich bald mehr über uns, als wir selbst oder handelt es sich um ein großes Missverständnis und maschinelle Emotionserkennung ist kaum mehr als technologischer Hokuspokus?

Die Werbebranche setzt schon etliche Jahre auf Emotionserkennung, um die Effekte von Werbebotschaften angeblich objektiver zu messen. Immer mehr Start-Ups aber auch die großen Technologiefirmen ziehen nach. Emotionserkennung ist ein wachsender Markt.

Software soll beispielsweise geeignete Jobanwärter auf Basis ihrer Mimik und Sprachmelodie identifizieren. Sicherheitsbehörden wollen verdächtige Personen und Verhaltensweisen ausmachen. Die Polizei von Lyon erfasst automatisch den Gemütszustand von Menschen, die eine Wachstube betreten.

Auch in der chinesischen Sicherheitsindustrie ist Emotionserkennung groß im Kommen und im Einsatz. Laut einem Bericht der Financial Times wird die uighurische Minderheit in Internierungslagern mit ähnlicher Technik auf unlautere Absichten gescreent. Die Fortschritte des maschinellen Lernens und anderer Methoden der künstlichen Intelligenz wecken und beflügeln viele Begehrlichkeiten.

Die Ursprünge liegen bei Darwin

Die wissenschaftliche Grundlage für Maschinen, die in unseren Gesichtern lesen können lieferte der US amerikanische Psychologe Paul Ekman.

Er entwickelt eine Theorie, die verspricht, Emotionen objektiv messbar zu machen. Sie basiert auf der Evolutionstheorie von Charles Darwin. Ekman geht davon aus, dass wir von Geburt an mit einem Set an Basis-Emotionen ausgestattet sind. Sie laufen gewissermaßen automatisch ab, als ¬Reaktion auf äußere Reize, und können deshalb auch weltweit, unabhängig vom kulturellen Hintergrund, nachgewiesen werden.

In den 1990er Jahren gründete die Informatikerin Rosalind Picard am MIT Medialab in Boston die Arbeitsgruppe „Affective Computing“ und ein paar Jahre später ein Spin-off mit dem Namen Affectiva.

Picard wollte Computern beibringen Gefühle zu erkennen und zu messen. Anfangs galt sie mit ihren Ideen als Exotin, doch mittlerweile ist das von ihr gegründete Unternehmen affectiva ein paar Millionen Dollar schwer und einer der Big Player auf dem Gebiet der maschinellen Emotionserkennung.

Grundlage der Algorithmen von Affectiva sind einerseits Paul Ekmans Theorien und andererseits ein großer Datenschatz an Bildern und Videos. Bilder von lächelnden, traurig oder angewidert dreinblickenden Menschen, denen eigens geschulte Mitarbeiter Emotionslabel verpasst haben.

Zweifel an den Basisemotionen

Doch viele Psychologinnen und Computerwissenschaftler zweifeln daran, dass man am Gesicht allein verlässlich Emotionen ablesen kann. Denn das Gesicht ist nicht nur eine Leinwand, auf die Gefühle wie ein Film projiziert werden, das Gesicht ist auch eine Art Interface, das ich gezielt steuern kann, um mit meinem Gegenüber zu kommunizieren. Jeder, der schon einmal in einer unangenehmen Situation ein Kampfgrinsen aufgesetzt hat, weiß, ein Lächeln kann auch trügerisch sein.

Dazu kommt: immer mehr Forscherinnen und Forscher zweifeln an, dass man den Gesichtsausdruck eines Menschen überhaupt einem eindeutigen Gefühl zuordnen kann. Eine der prominentesten Zweiflerinnen ist die Psychologin Lisa Feldmann Barrett von der Northeastern University in Boston.

Vor knapp einem Jahr hat sie eine umfangreiche Metastudie über den Ausdruck und die Wahrnehmung von Emotionen über das Gesicht vorgelegt. Sie hat sich dafür gemeinsam mit Kollegen tausend zu dem Thema publizierte Studien angesehen. Die Annahme, dass ein bestimmter Gesichtsausdruck, ein Lächeln oder zusammengezogene Augenbrauen wie eine Art Fingerabdruck eindeutig ein Gefühl ausdrücken, konnten sie nicht betätigen.

Die meisten schauen gar nicht böse, wenn sie wütend sind

Denn nur 30 Prozent der Menschen, die wütend sind, runzeln die Stirn, sagte Lisa Feldmann Barrett vor kurzem auf der Jahrestagung der Amerikanischen Gesellschaft zur Förderung der Wissenschaften, der AAAS. Meistens schauen Menschen gar nicht böse, wenn sie wütend sind. Und Menschen blicken manchmal finster, wenn sie gut gelaunt sind, weil sie sich konzentrieren, weil ihnen jemand einen schlechten Witz erzählt oder weil der Bauch drückt, so Feldmann Barrett.

Ein Gesichtsausdruck ist viel zu unspezifisch, um daraus solide eine Gemütslage abzuleiten, er hat per se keine ihm eingeschriebene Bedeutung. Einheitliche und universelle Mikroexpressionen der Gefühle in Gesichtern lassen sich nicht feststellen. Gesichtserkennungssoftware sei viel zu unzuverlässig, um sie auf die Menschheit loszulassen, ist die klare Message der Psychologin.

Maschinen scheitern genauso wie der Mensch

Am Ende gibt es eine gute und eine schlechte Nachricht: Maschinen scheitern genauso wie der Mensch daran, aus einem Gesicht zuverlässig Emotionen abzulesen. Die schlechte Nachricht: Techfirmen, die ihr Gesicht- und Emotionserkennungsarsenal anpreisen, schreiben das nicht in ihre Werbetexte.

Vielleicht ist vielen Unternehmen, die auf automatische Bewerbung setzen, auch egal, nach welchem Prinzip sie unter Bewerbern eine grobe Vorauswahl treffen. Ehrlicher wäre es aber wahrscheinlich, sie würden dafür Tarotkarten legen.